Når du har en hjemmeside, vil du selvfølgelig gerne have at Google og de andre søgemaskiner, indexerer det hele. Desværre er de fleste CMS-systemer overivrige, og viser det samme indhold på flere måder.

Når du har en hjemmeside, vil du selvfølgelig gerne have at Google og de andre søgemaskiner, indexerer det hele. Desværre er de fleste CMS-systemer overivrige, og viser det samme indhold på flere måder.

Dette indlæg fortæller hvordan du kan udnytte robots.txt til at søgemaskineoptimere så du bliver synlig på den rigtige måde, uden duplicate kontent.

Samtidig kan det være rigtig ærgerligt, hvis søgemaskinerne registrere et pdf-dokument som det vigtigste på dit websted. Du har f.eks. lavet en artikel om agurkers krumningsprocenter, og henviser til et pdf-dokument med de statistiske oplysninger. Hvis søgemaskinerne vurderer at pdf-dokumentet er vigtigere end den side du har lavet, kommer de besøgende hen til pdf-dokumentet, og ikke til din side.

Samtidig kan det være rigtig ærgerligt, hvis søgemaskinerne registrere et pdf-dokument som det vigtigste på dit websted. Du har f.eks. lavet en artikel om agurkers krumningsprocenter, og henviser til et pdf-dokument med de statistiske oplysninger. Hvis søgemaskinerne vurderer at pdf-dokumentet er vigtigere end den side du har lavet, kommer de besøgende hen til pdf-dokumentet, og ikke til din side.

Det er en katastrofe, men hvorfor?

Når brugeren ser dit pdf-dokument, er der ingen navigation, og du får ikke lov til at vise flere sider til den bruger, medmindre brugeren ved, at url-adressen kan afkortes lidt, for at se selve hjemmesiden. Men det gider de færreste at gør!

En anden uheldig egenskab er, at ofte tages nogle sætninger fra pdf-dokumentet, hvorfor opfinde den geniale tekst to gange, og så er der pludselig duplicate content, som er direkte skadeligt for din rangering.

Hvordan bruges robots.txt så!

Robots.txt er et helt almindeligt tekstdokument, der gemmes i roden af dit websted. Indholdet kan bestemme hvad søgemaskinerne (Google, Bing, Yahoo mfl.) må gemme af oplysninger fra dit websted. Det er nogle retningslinjer, og der er vidt forskellige holdninger om hvorvidt de overholder dem eller ej. Google hævder de respekterer det der står i robots.txt, men kan sikkert godt finde på at kigge på det indhold der ikke må indexeres!

For at begrænse indholdet, starter vi med at fortælle hvem der skal tage hensyn til det, ved at skrive

User-agent: *

Linjen beskriver blot at “alle der kommer forbi” i princippet skal følge vores råd.

Hvis du er i testfasen bør du have adgangsbegrænsning på dit websted, men alternativt kan du bare sørge for at intet indexeres, så bliver du ikke set i søgninger.

Intet på webstedet må indexeres:

Disallow: /

Begrænsning af en mappe, f.eks. fortrolige-dokumenter:

Disallow: /fortrolige-dokumenter/

Begrænsning så pdf-dokumenter ikke vises:

Disallow: /*.pdf$

Begrænsning af helt bestemt dokument:

Disallow: /mine-hemmelige-koder.html

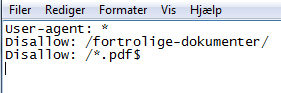

Du kan kombinere det efter eget valg. Det kunne måske se sådan ud:

Du skal bare huske på, at alt hvad du skriver i robots.txt kan ses af alle. Dvs. hvis du tester, og blot undlader at indexere, kan nysgerrige personer måske prøve at se hvad du har i de mapper der ikke må indexeres, så det skal ikke være noget fortroligt 😉

Undersøg dit websted

Når du skal have gavn af robots.txt, skal du først undersøge dit websted. Hvis du ved du har lavet 50 artikler/indlæg, og Google mener der er 500, må nogle af dem gå igen. Og spøgelser er noget rod, der er duplicate content, det samme indhold der gentages flere gange på webstedet.

F.eks. bruger WordPress noget der hedder tags, og lige umiddelbart optræder alle artikler både i kategorier og i tags – alle de tags du har tildelt et indlæg. Hvis du har styr på din struktur, og har en liste over dine kategorier, f.eks. i en widget, vil du med fordel kunne fortælle Google at tags-artiklerne ikke skal indexeres. Typiske ser det således ud:

http://webdesign-og-soegemaskineoptimering.dk/tag/reference/

For at udelade tagsvisningen, kan du lave en linje med:

Disallow: /tag/

Altså nøjagtig som ved undermapper. Undersøg nøje hvilke sider Google har registreret, ved at bruge:

site:dit-domæne.dk

i Googlesøgefeltet. Så har du en god ide om hvordan Google ser på dit websted.

…

Hav en fortsat fantastisk god dag